2021. 2. 16. 07:50ㆍUI 가벼운 이야기

들어가며

디지털 전환기를 맞이해서 온라인과 오프라인이 혼재됨에 따라 많은 새로운 서비스들이 생겨나고 있습니다. 최근에 디지털 전환기를 맞이하여 완전하게 디지털 기술이 적용된 최적의 경험을 사용자에게 제공하는 것일까?라는 의문을 시작으로

"우리는 너무 화면을 잘 만드는 데에만 치중하고 있는 것은 아닌가? 너무 유저만 보고 있는 것은 아닌가? 디지털 전환기에 시스템, 환경 자체가 변하고 있는데?"

라는 의문이 생겼습니다. 디지털 전환은 단순히 디지털화된 환경에서 경험을 제공하거나 디지털 기술의 적용을 뜻하는 것이 아닌 새로운 디지털 기술의 적용을 통한 환경의 변화로 새로운 가치를 생성, 공유하는 것을 말합니다.

따라서 이글에서 디지털 전환을 위해 UX 디자인 시에 생각해볼 만한 요소들에 대해 정리해보고자 합니다.

디지털 공간을 넘어 물리적 공간으로

많은 산업이 디지털화(Digitalisation)되면서 많은 활동들이 디지털 세상에서 행해지면서 스크린으로 옮겨져 왔습니다. 서비스들이 스크린을 기반으로 제공되고 이에 따라 사용자의 경험을 디자인을 할 때 당연하게 스크린만을 터치포인트로 생각하고 화면 내에서만 어떻게 더 효율적으로 정보를 전달하고 액션을 불러일으킬 것인지에서만 고민하는 것이 아닌가란 생각이 들었습니다 (물론 프로젝트의 상황에 따라 다릅니다). 이는 오늘날 산업의 대부분의 프로덕트가 화면기반인 웹서비스나 앱이기 때문일 텐데요.

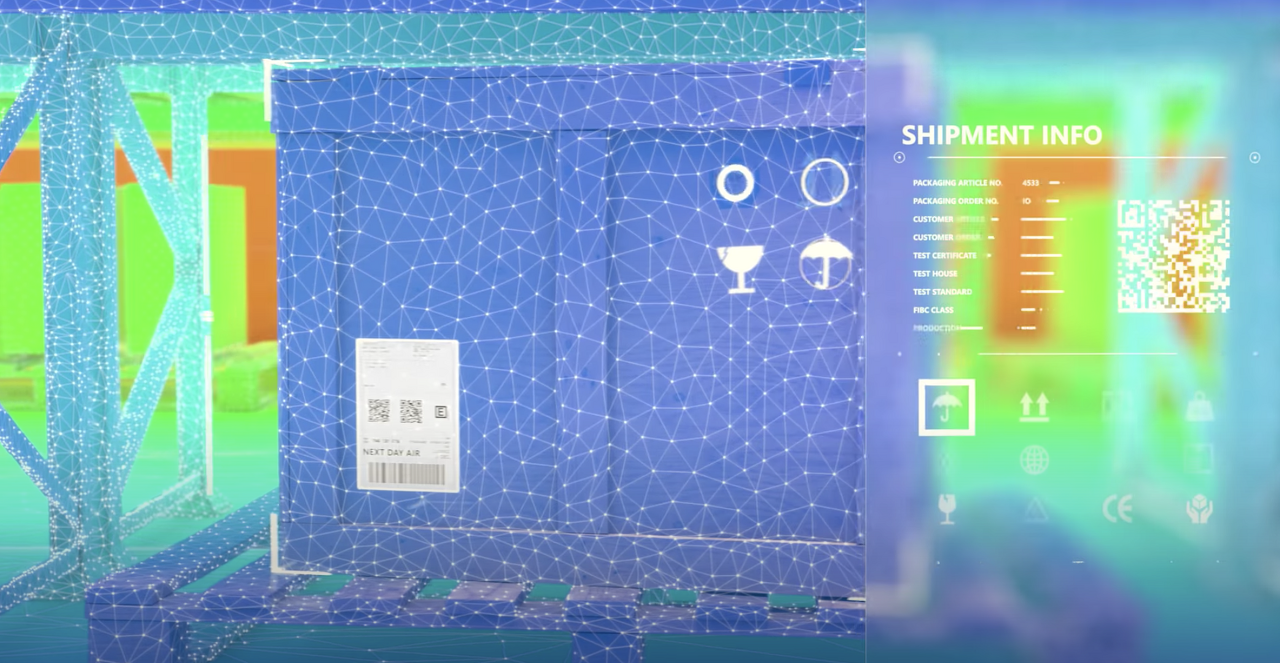

디지털 전환기에 디지털 서비스들이 오프라인으로 침투해 감에 따라 디지털 서비스들이 사용자들이 머무는 물리적 공간에서의 정보들을 얻을 수 있는 환경이 만들어지고 있습니다. 따라서 앞으로 사용자의 경험을 고민할 때 디지털뿐만 아니라 오프라인 나아가 디지털과 오프라인이 혼재되는 폭넓은 터치포인트의 고민이 필요한 것 같습니다. 이를 잘 보여주는 사례로 이제는 상용화가 되어가고 있는 무인 편의점을 들 수 있습니다.

아마존 고와 같은 무인서비스에서 사용자의 터치포인트를 스크린으로만 생각하였다면, 앱을 열어서 바코드를 찍어서 현장 결재하는 것과 같은 방향으로 생각하지 않았을까요?(물론 아닐 수도 있습니다) 디지털 전환기에 더 나은 사용자에게 경험을 제공하여 사용자의 행동을 바꾸고 나은 생활을 제공하려면 사용자를 행동하게 하는 것이 아니라 그전에 사용자의 상황을 이해하는 것이 필요하다고 생각합니다. 따라서 디지털 전환기에 사용자의 경험을 설계하고 디자인한다면 사용자의 콘텍스트를 인지하는 방식에 대한 고민이 필요할 것으로 생각됩니다.

문맥 인지를 넘어 (beyond context recognition to context understanding)

이미 오래전부터 매일 가지고 다니고 언제나 사용하는 스마트폰을 통해 콘텍스트를 인지하는 방법에 대해서 고민이 되어왔고 이는 5G와 빅데이터의 기술의 향상으로 더욱더 우리 곁에 가까이 와있다고 볼 수 있습니다. 기존까지 화면을 기반으로 경험을 제공하는 것이 공간으로 확장될 가능성이 높아짐에 따라 공간에서의 사용자의 콘텍스트를 인지하는 것이 중요할 것으로 생각됩니다. 이를 위해 다양한 센서를 기반으로 사용자의 상황을 인지하기 위한 기술적 시도가 계속되고 있습니다.

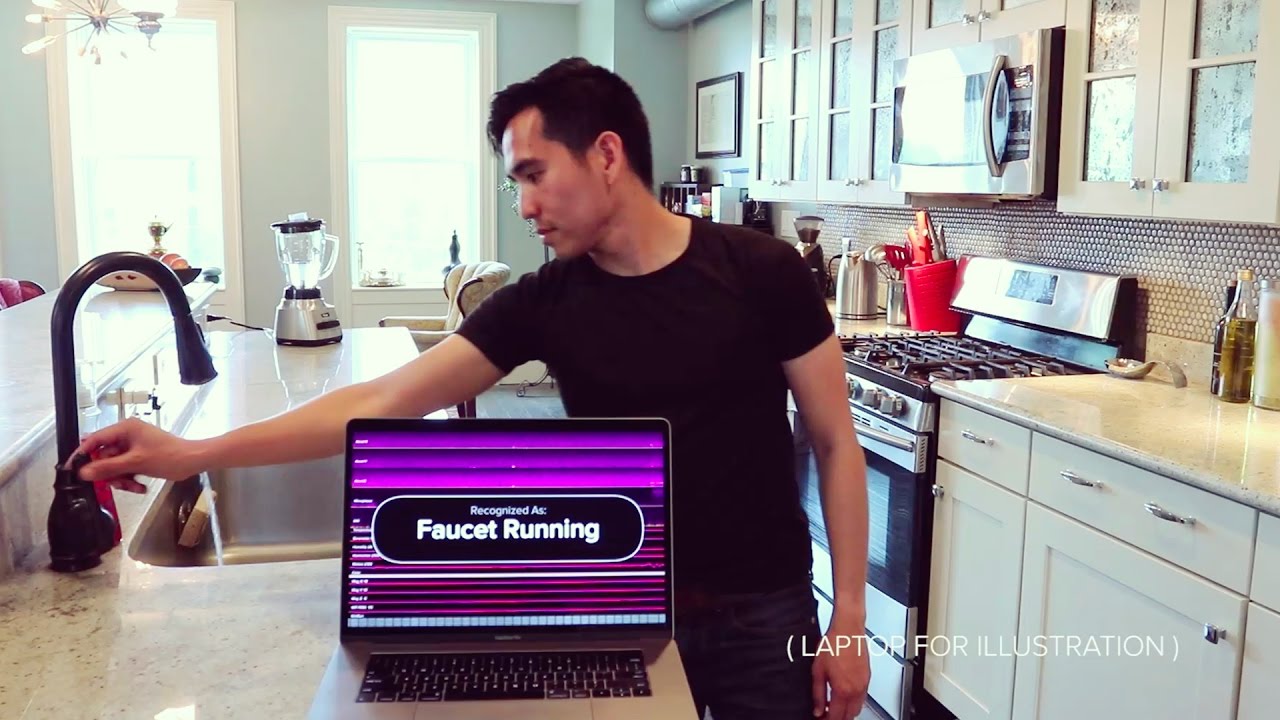

이는 요즘 많이 언급되고 있는 언택트 서비스에서 사용자를 이해하기 위해 특히 필요한 부분이라고 생각됩니다. 또한 많은 스마트 어시스턴트들이 똑똑해짐에 따라 사용자 주변에서 사용자를 인지하기 위한 준비를 하고 있습니다. 다양한 센소리(Sensory) 채널인 시각, 청각, 촉각 등을 활용할 수 있는 멀티모달 인터랙션 기술이 필요한 시점이라고 할 수 있습니다. AI를 기반으로 한 비전과 소리는 이미 우리의 일상생활에 많이 들어와 있습니다. 사진을 찍으면 표정을 인식한다거나 사진에 있는 텍스트를 읽는다거나 어떤 사물을 찍고 있다거나 하는 것을 통해 여러 서비스들이 제공되고 있습니다. 또한 소리로 콘텍스트를 읽는 기술 또한 실험단계를 넘어 상용화를 앞두고 있습니다.

개인화를 넘어 초 개인화로

사용자의 콘텍스트를 인지하고 이해한다면 어떠한 서비스가 가능할까요? 사용자의 콘텍스트를 이해한다는 것은 사용자의 의도를 이해하고 제안할 수 있는 단계라고 할 수 있습니다.

1. Prediction에서 Understanding으로

기존의 히스토리 데이터를 분석하여 어떤 것이 필요할 것이다 예측하는 것이 아닌 사용자를 이해할 수 있는 단서를 다양한 센소리(Sensory)로 획득이 가능함으로써 사용자의 행동을 이해하여 의도를 더욱 정확하게 파악할 수 있습니다.

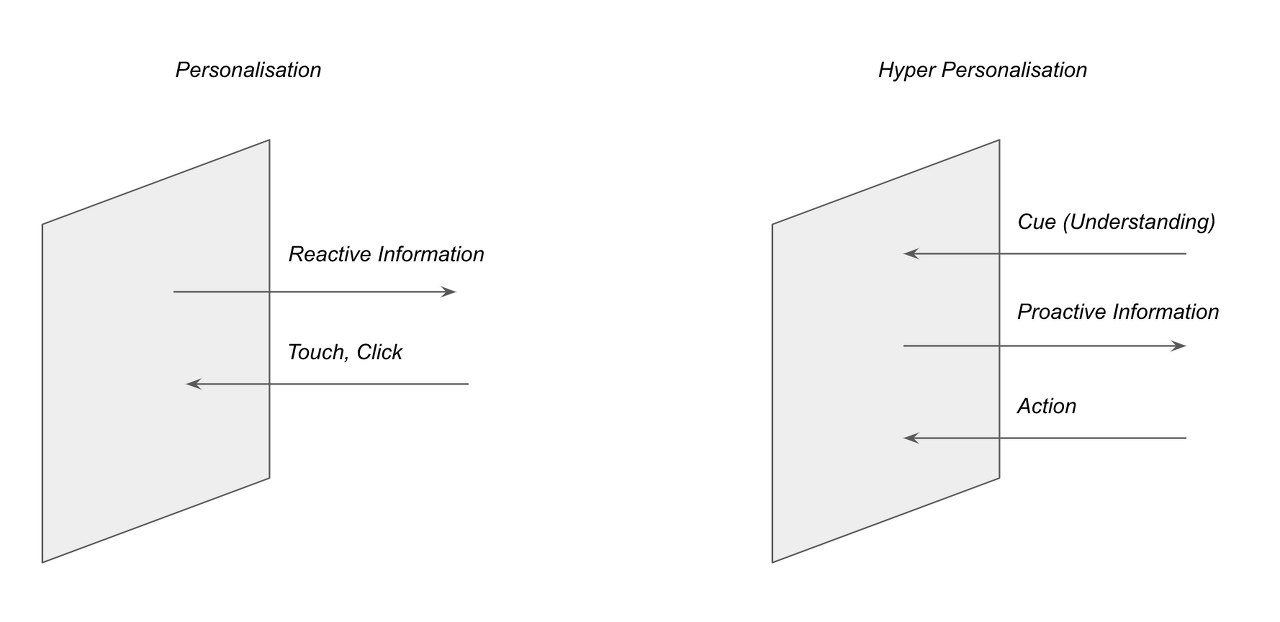

2. Reactive에서 Proactive로

사용자를 이해하게 됨으로써 사용자의 행동에 반응하는 것이 아닌 미리 어떤 것을 제안하는 서비스가 가능해질 것으로 생각됩니다. 스마트 어시스턴트에 마이크로 소리뿐만 아니라 비전 센서로 사용자의 행동을 이해할 수 있다면 더욱더 마이크로화 된 개인화된 서비스가 가능해질 것으로 생각됩니다.

기존의 화면 내에서 정보를 제공하고 이에 대한 클릭, 터치를 이끌어 내는 방식의 인터랙션 방식이 주를 이루었다고 하면 사용자의 콘텍스트를 인지하기 위한 다양한 센서들의 활용을 통해 사용자를 이해할 수 있는 단서들을 획득하고 이에 따른 Proactive 한 콘텐츠를 제공하는 초개인화된 서비스를 제공할 수 있습니다. 이에 대한 액션은 기존의 클릭, 터치뿐만 아니라 보이스, 표정, 손짓이 포함될 수 있습니다. 이러한 방식을 통해 실시간으로 사용자의 상황에 맞게 콘텐츠를 제공하여 온택트 서비스에서의 경험을 더욱 풍성하게 할 수 있을 것입니다.

마치며

디지털 전환은 단순히 디지털 공간 내에서 새로운 기술의 적용, 접목을 의미하는 것만은 아닙니다. 실제 공간에서 휘발되는 정보를 디지털화시켜 이를 활용하여 새로운 가치를 생성, 공유, 활용하는 것을 고민해봐야 하는 시기라고 생각됩니다. 마지막으로 이러한 흐름을 잘 보여주는 마이크로소프트의 애저 키넥트 카메라(Azure Kinect Camera)를 보시면 이글에서 말하고자 하는 바를 조금 더 이해하실 수 있을 것 같습니다.

이번주도 고맙습니다.

*이 글은Minwoo Kim의 브런치에서도 보실 수 있습니다.

그림 1. amazon gohttps://www.amazon.com/b?ie=UTF8&node=16008589011

그림 2. Synthetic Sensorhttp://www.gierad.com/projects/supersensor/

그림 3. Azure Kinect Camerahttps://www.youtube.com/watch?v=jJglCYFiodI&feature=youtu.be